728x90

인간의 언어를 이해하는 AI의 비밀

오늘은 자연어 딥러닝-RNN에 대 알아보자.

| 오늘의 배움 |

|

1. 자연어 딥러닝이란?

정의: 텍스트 데이터에 신경망 모델을 활용하여 의미를 학습하고 다양한 작업을 수행하는 기술

핵심 개념 한 줄 설명: 컴퓨터가 인간의 언어를 이해하고 처리할 수 있도록 하는 인공지능 기술

특징:

- 대량의 텍스트 데이터를 학습함

- 단어나 문장의 의미와 문맥을 파악함

- 다양한 자연어 처리 작업(번역, 감정분석 등)을 수행함

필요성:

- 인간과 기계 간의 자연스러운 소통을 위해 필수적

- 방대한 텍스트 정보를 자동으로 분석하고 처리하기 위함

장점/단점:

- 장점: 인간의 개입 없이 텍스트를 이해하고 처리 가능, 다양한 언어에 적용 가능

- 단점: 많은 학습 데이터와 컴퓨팅 자원이 필요, 완벽한 이해는 여전히 어려움

예시:

- 스마트폰 음성비서(시리, 빅스비)

- 자동번역 서비스(파파고, 구글 번역)

- 챗봇 서비스

[핵심 공식]

- 텍스트 데이터 → 전처리 → 수치 변환 → 딥러닝 모델 학습 → 결과 출력

- 입력 시퀀스(x1, x2, ..., xn) → 모델 → 출력(y)

- h_t = tanh(W_h·h_{t-1} + W_x·x_t + b_h) [RNN 은닉 상태 계산식]

입력: "오늘 저녁에 같이"

↓

RNN 처리

↓

예측 결과: 1. "먹을까요?" (확률 60%)

2. "영화 볼까요?" (확률 25%)

3. "만날까요?" (확률 15%)

2. 핵심 개념 정리

2-1. 시퀀스 데이터/순차 데이터

- 정의: 요소들이 특정 순서로 정렬되어 있고, 순서가 의미를 결정하는 데이터 유형

- 작동 원리: 데이터의 시간적/순차적 관계를 보존하며 분석함

- 특징:

- 순서가 중요함 (단어 순서에 따라 문장 의미가 달라짐)

- 시점 정보를 포함함

- 연속성을 가짐

- 장점/단점:

- 장점: 시간에 따른 패턴 파악 가능

- 단점: 복잡한 모델 구조 필요, 학습 시간이 김

- 필요성: 시간에 따라 변화하는 데이터 분석에 필수적

- 분석 방법

- 통계적 분석: 이동 평균, 분산 분석 등을 통해 시간 또는 순서의 변화 패턴 파악

- 머신러닝: Recurrent Neural Network(RNN), Long Short-Term Memory(LSTM), Gated Recurrent Unit(GRU) 등 순차 데이터 학습을 위한 신경망 사용

- 트랜스포머 모델: 자연어 처리 및 시계열 분석에서 효율적으로 순차적 패턴을 학습

- 예시:

# 순차 데이터 예시 - 시계열 데이터

temperature_data = [20.5, 21.2, 22.0, 23.1, 22.5] # 5일간의 온도 기록

text_data = ["안녕", "나는", "인공지능", "공부", "중이야"] # 단어 시퀀스

2-2. 순환 신경망(RNN)

- 정의: 순차적인 데이터를 처리하기 위해 이전 정보를 기억하는 구조의 신경망

- 작동 원리: 이전 상태의 정보(은닉 상태)를 현재 계산에 포함시켜 순차적 패턴 학습

- 순환 구조: RNN은 이전의 출력 또는 은닉 상태를 다음 계산에 반영하여 시간에 따른 정보를 기억한다.

- 은닉 상태(Hidden State): 이전 시점의 정보를 현재 시점으로 전달하는 역할을 한다.

- 시간 전개(Time Unfolding): 시퀀스의 길이에 따라 동일한 구조가 반복되며, 각 시점마다 입력과 은닉 상태를 업데이트한다.

⇒ RNN을 순서대로 펼쳐 놓으면 weight을 공유하는 매우 깊은 신경망이 된다.

⇒ RNN의 오차역전파는 BPTT (Backpropagation Through Time)으로 처리된다.

- 특징

- 특화: 시퀀스 데이터 처리에 강점

- 기억 능력: 이전 입력을 '기억'하며 처리

- 네트워크는 입력 데이터를 요약하여 기억을 저장

- 새로운 입력이 들어올 때마다 기억을 조금씩 수정

- 모든 입력을 처리한 후, 남은 기억은 시퀀스를 전체적으로 요약하는 정보로 활용

- 반복적 처리: 입력마다 기억을 갱신하며 순환적으로 진행 (사람이 단어를 기억하며 이해하는 방식과 유사)

- RNN 구현체

- RNN: 단순 구조, 기울기 소멸 문제 발생

- LSTM: 게이트 구조 추가로 장기 의존성을 처리

- GRU: LSTM보다 간단한 구조로 비슷한 성능 제공

- 필요성: 텍스트, 음성, 시계열 데이터 등 순차적 패턴을 가진 데이터 처리에 필요

- 예시:

# RNN 기본 구현 예시 (PyTorch)

import torch.nn as nn

class SimpleRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(SimpleRNN, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

# x 형태: (batch_size, sequence_length, input_size)

output, hidden = self.rnn(x)

# 마지막 시점의 출력으로 분류

out = self.fc(hidden.squeeze(0))

return out

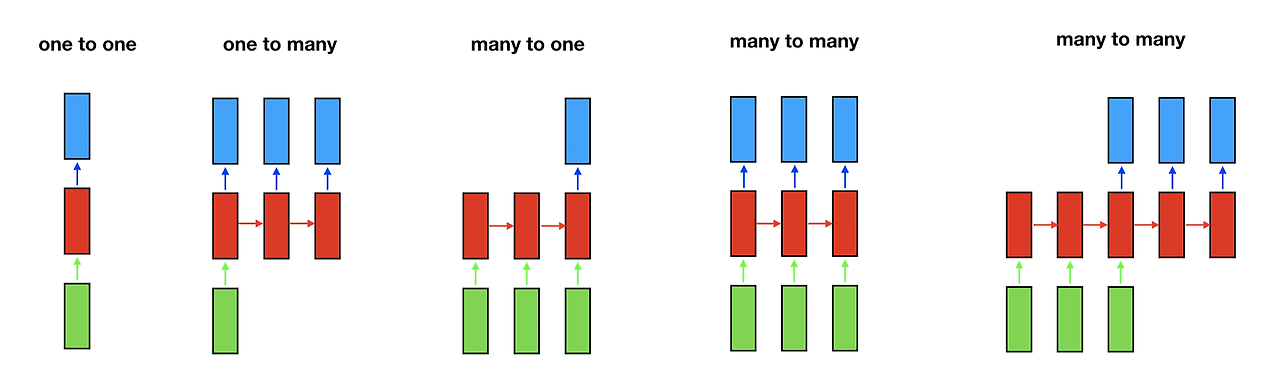

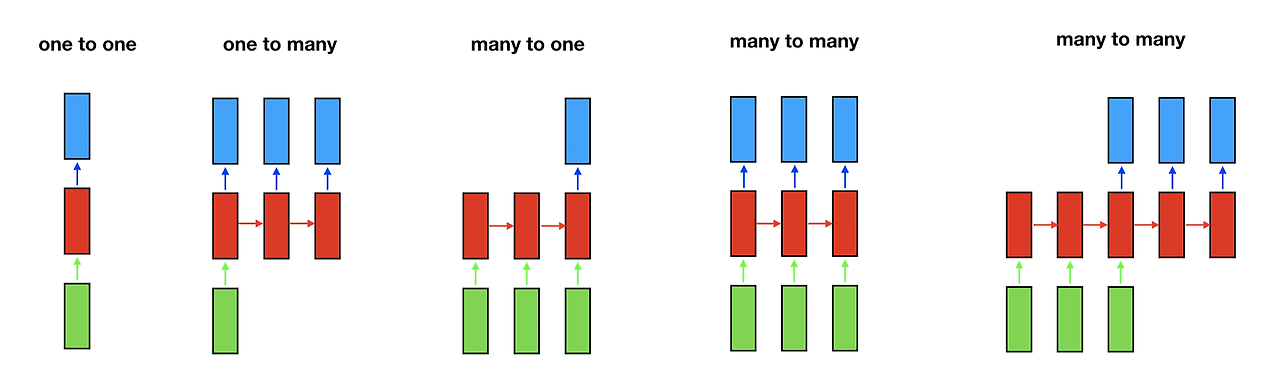

2-3. RNN의 입출력 타입

- 정의: RNN이 처리할 수 있는 다양한 입력-출력 구조 형태

- 작동 원리: 태스크에 따라 적절한 입출력 구조를 선택하여 모델 설계

- 특징:

- 다섯 가지 기본 구조(One-to-One, One-to-Many, Many-to-One, Many-to-Many)

- 태스크에 맞는 구조 선택 가능

더보기

- One-to-One

- 입력 데이터 하나에 출력 데이터 하나를 생성하는 구조

- 이미지 분류 (Image Classification)

- 입력 데이터 하나에 출력 데이터 하나를 생성하는 구조

- One-to-Many

- 하나의 입력 데이터를 기반으로 다수의 출력 시퀀스를 생성

- 이미지로부터 문장 생성 (Image Captioning)

- 작곡, 작사

- 하나의 입력 데이터를 기반으로 다수의 출력 시퀀스를 생성

- Many-to-One

- 여러 입력 시퀀스를 받아 하나의 출력 데이터를 생성

- 감정 분석 (Sentiment Analysis, 예: Positive/Negative)

- 스팸 탐지 (Spam Detection)

- 여러 입력 시퀀스를 받아 하나의 출력 데이터를 생성

- Many-to-Many (동일 길이)

- 입력과 출력 시퀀스의 길이가 동일한 구조

- Video 각 frame에 label 생성

- 품사 태깅 (Part-of-Speech Tagging)

- 개체명 인식 (Named Entity Recognition)

- Character 단위 문장 생성

- 입력과 출력 시퀀스의 길이가 동일한 구조

- Many-to-Many (다른 길이)

- 입력과 출력 시퀀스의 길이가 다를 수 있는 구조

- 기계 번역 (영어 → 한국어 문장)

- 챗봇 (Chatbot)

- 질문 응답 (Question Answering)

- 입력과 출력 시퀀스의 길이가 다를 수 있는 구조

- 장점/단점:

- 장점: 다양한 자연어 처리 문제에 유연하게 적용 가능

- 단점: 복잡한 구조일수록 학습이 어려움

- 필요성: 다양한 형태의 자연어 처리 작업을 수행하기 위함

- 예시

# Many-to-One RNN 예시 (감정 분석)

sentences = ["이 영화는 정말 재미있었어요", "오늘 날씨가 좋네요", "이 제품은 품질이 좋지 않아요"]

labels = ["긍정", "중립", "부정"]

# 모델이 전체 문장(Many)을 입력받아 하나의 감정 레이블(One)을 출력입력(영어): "I love studying artificial intelligence."

↓

RNN 처리 과정:

1. 단어 임베딩: 각 단어를 벡터로 변환

2. 인코더 RNN: 영어 문장의 의미를 인코딩

3. 디코더 RNN: 한국어 문장으로 디코딩

↓

출력(한국어): "나는 인공지능 공부하는 것을 좋아한다."

3. 비교 분석표

| 구분 | RNN | LSTM | GRU | 일반 신경망(MLP) |

| 특징 | 기본적인 순환 구조 | 게이트 메커니즘으로 장기 기억 강화 | LSTM의 간소화 버전 | 순환 구조 없음 |

| 장점 | 구조 단순, 구현 쉬움 | 장기 의존성 문제 해결, 정보 선택적 저장 | LSTM보다 빠른 학습, 적은 파라미터 | 구현 간단, 학습 빠름 |

| 단점 | 장기 의존성 문제, 그래디언트 소실 | 구조 복잡, 계산량 많음 | 장기 기억력이 LSTM보다 약함 | 순차 데이터 처리 부적합 |

| 작동원리 | 단순한 순환 연결로 이전 정보 전달 | 입력/출력/망각 게이트로 정보 제어 | 리셋/업데이트 게이트로 정보 제어 | 층별 순방향 전파만 수행 |

| 개념 코드 예시 | h_t = tanh(W_h·h_t-1 + W_x·x_t + b) | f_t, i_t, o_t, c_t 게이트 사용 | r_t, z_t 게이트 사용 | y = activation(W·x + b) |

| 활용사례 | 간단한 시퀀스 예측, 문장 감정 분석 | 기계 번역, 음성 인식, 복잡한 시계열 예측 | 텍스트 생성, 감정 분석 | 이미지 분류, 회귀 분석 |

728x90

'Develop > AI' 카테고리의 다른 글

| 자연어 처리 요약 정리(2) (0) | 2025.02.23 |

|---|---|

| 자연어 딥러닝 기초 - LSTM을 알아보자. (2) | 2025.02.23 |

| 자연어 임베딩 이해를 알아보자. (6) | 2025.02.21 |

| Subword Tokenizing을 알아보자. (0) | 2025.02.19 |

| 어간 추출 알아보자. (0) | 2025.02.19 |